随着人工智能技术的飞速发展,AI手机已从概念走向现实,成为消费电子市场的新宠。从智能语音助手、场景化拍照优化到个性化内容推荐,AI深度融入手机操作系统的各个环节,极大地提升了用户体验与设备性能。在AI手机锋芒毕露、展现强大能力的一个严峻的问题也随之凸显:用户隐私与数据安全正面临前所未有的挑战。这不仅关乎个人权益,也对网络与信息安全软件开发提出了更高、更紧迫的要求。

一、AI手机的崛起与隐私隐忧

AI手机的核心在于其强大的数据处理和学习能力。为了实现精准的服务,它需要持续收集、分析用户的通信记录、位置信息、浏览习惯、社交关系乃至生物特征等海量敏感数据。这些数据在云端和终端间频繁流动,构成了用户的“数字镜像”。数据收集的广度与深度,也意味着一旦发生泄露、滥用或被非法访问,其后果将极为严重。例如,深度伪造技术可能利用人脸、声纹数据实施诈骗;个性化推荐算法若被恶意操纵,可能成为传播虚假信息、进行精神操控的工具;而云端服务器的安全漏洞,更可能导致大规模数据泄露事件。AI在赋予手机“智慧”的也使其成为了隐私泄露的高风险节点。

二、安全威胁的多维演化

与传统手机安全威胁相比,AI手机面临的风险更为复杂多维:

- 模型安全风险:AI模型本身可能含有偏见或被“投毒”(植入恶意数据),导致其决策出现偏差或被攻击者逆向工程,窃取训练数据。

- 数据生命周期风险:数据在采集、传输、存储、处理、销毁的每一个环节都可能遭遇拦截、窃取或篡改。AI所需的持续学习机制,使得数据长期处于“活跃”状态,增加了暴露风险。

- 新型攻击面:攻击者可能利用AI系统的特性,发起对抗性攻击(例如,对图像加入人眼难以察觉的扰动,导致AI识别错误),或利用AI能力自动化、规模化地发动网络攻击。

- 合规与伦理风险:全球数据保护法规(如GDPR、中国的《个人信息保护法》)日趋严格,AI手机如何在提供智能服务与遵守“最小必要原则”、“知情同意原则”之间取得平衡,是厂商必须解决的难题。

三、网络与信息安全软件开发的应对之道

面对上述挑战,网络与信息安全软件开发必须进行范式升级,从被动防御转向主动、内生、全生命周期的智能安全守护。

- 开发隐私增强技术(PETs)集成方案:安全软件需深度整合联邦学习、差分隐私、同态加密、安全多方计算等技术。例如,推动联邦学习在手机端的落地,使得AI模型可以在数据不出本地设备的情况下进行协同训练,从根本上降低数据集中泄露的风险。安全软件应提供易于调用的SDK或API,帮助应用开发者便捷地实现隐私保护功能。

- 构建终端-云端协同的智能安全防御体系:在手机终端,开发轻量化、低功耗的本地AI安全引擎,实时检测异常应用行为、识别对抗性样本、监控敏感数据调用。在云端,建立基于大数据和AI的安全分析平台,对来自海量终端的威胁情报进行关联分析,实现威胁的快速感知、预警和响应。终端与云端协同,形成动态防御能力。

- 聚焦AI模型安全与可解释性:开发专门用于检测和加固AI模型的安全工具,包括模型完整性验证、对抗样本检测与防御、后门攻击检测等。推动开发可解释性AI(XAI)工具,让用户和安全分析师能够理解AI的决策逻辑,增加透明度,便于审计和发现潜在风险。

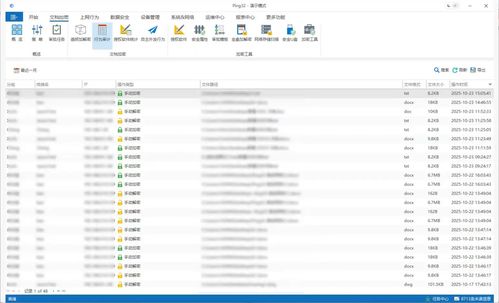

- 实现数据流动的全程可视化与可控化:安全软件应提供清晰、直观的数据看板,让用户一目了然地知晓哪些应用在何时访问了何种数据、用于何种目的。提供精细化的权限管理和数据访问控制策略,允许用户随时撤销授权,甚至提供“数据沙盒”和“隐私计算空间”等功能,对高度敏感的操作进行隔离保护。

- 拥抱安全开发左移与合规自动化:将安全考量嵌入AI手机应用与系统开发的初始阶段(安全开发左移)。开发工具应集成隐私影响评估(PIA)、数据映射、合规性检查等自动化功能,帮助开发团队在设计之初就规避隐私风险,并自动生成符合法规要求的文档,降低合规成本。

四、

AI手机的蓬勃发展是技术进步的必然,但其光辉不应以牺牲用户隐私与安全为代价。隐私安全不是AI发展的“绊脚石”,而是其行稳致远的“压舱石”。这要求手机制造商、应用开发者、安全软件厂商、监管机构乃至每一位用户共同参与,构建一个多方协同的治理生态。其中,网络与信息安全软件开发扮演着至关重要的“守护者”角色。唯有通过持续的技术创新,打造更智能、更透明、更可信的安全解决方案,才能在AI赋能万物互联的时代,真正守护好每个人的数字家园,让科技进步的福祉安全、安心地惠及所有人。